Le 18 mars 2018, un véhicule autonome de l’entreprise Uber percute un piéton dans l’Arizona. C’est le premier accident mortel lié au véhicule autonome. Ce triste constat, repris par la presse et par les entreprises qui développent ces modèles de voitures, est analysé par Boris Beaude, professeur en cultures, sociétés et humanités numériques à Université de Lausanne. Il annonce de facto « on appelle cela intelligence car il y a un processus cognitif de traitement mais cela n’a pas beaucoup de rapport avec notre façon de raisonner1 ». En effet, on peut trouver un bon nombre de spéculations sur le terme d’intelligence artificielle mais celle-ci reste cantonnée à des environnements de calculs très spécifiques. L’intelligence artificielle utilise un algorithme d’apprentissage automatique, appelée aussi Machine Learning. C’est un apprentissage qui utilise des données brutes, jusqu’à produire un modèle. Puis le modèle peut être utilisé pour faire des prédictions. Par l’apprentissage, l’algorithme élabore des catégories qui relèvent du signe. En effet, la machine développe un système spécifique par rapport aux données qu’il analyse. L’algorithme suit les motifs récurrents qu’il a aperçu lors de son apprentissage. Cependant sa réflexion suit un modèle « boîte noire », c’est-à-dire que personne ne sait comment l’algorithme arrive à son résultat computationnel. L’étude des systèmes de signes formalisés par la machine permet ainsi de mieux comprendre son fonctionnement et sa propre compréhension des données. Notre langage formalise notre façon d’appréhender le monde, qu’en est-il de la machine ? Dans le cas des véhicules autonomes, plusieurs algorithmes fonctionnent simultanément : celui qui nous intéresse pour comprendre le dramatique accident est celui de reconnaissance d’images. Comment la machine élabore-elle un concept ? Comment la machine peut comprendre un signe, alors qu’elle n’a à priori aucune connaissance du concept. C’est ce que l’on peut penser après l’accident. Évidemment, le système embarqué a connaissance du concept de « piéton ». Boris Beaude dans son exposé montre des exemples de vidéos de dashcams (caméras embarquées à l’avant d’une voiture retranscrivant la vue du pilote), issus de modèle de voiture Tesla. Les vidéos montrent des exemples de machine vision où les véhicules s'arrêtent aux passages des piétons. D’où vient l’accident ? Défauts dans les capteurs2 ou défauts dans l’algorithme utilisé, c’est à dire dans le système de signes produit par l’IA ? L’algorithme prend en entrée les différentes images des capteurs : chaque pixel est analysé mais aucun ne fournissent dans l’absolu de données tangibles. Indépendamment, les pixels n’ont aucune valeur. Est-ce que la silhouette n’a pas été perçue par l’algorithme d’Uber à cause du fait que l’individu traversait avec un vélo ? La police américaine mène l’enquête : elle dispose en tout cas d’une multitude de preuves avec l’enregistrement automatique de toutes les données par ces systèmes. Dans ce contexte du développement de la voiture autonome le Massachusetts Institute of Technology (M.I.T) propose le projet Moral Machine. Sur ledit site les utilisateurs peuvent choisir ce qu’une machine autonome devrait faire, dans le cas où le système de frein de la voiture est défaillant et qu’elle est obligée de renverser des personnes. L’utilisateur a un dilemme moral : renverser des personnes âgées sur un passage piéton ou des enfants. Ou encore des cadres et médecins face à des personnes sans domiciles fixes. Les choix des utilisateurs sont enregistrés dans le cadre d’une étude. La plateforme a pour objectif de produire un débat au sein de la société sur les éventuels scénarios et de leur conséquence morale ainsi que d’élaborer une opinion sur la façon dont les machines doivent prendre des décisions. Pour Boris Beaude, cette analyse ne correspond pas à la réalité : la machine est capable de distinguer un individu mais elle n’est pas assez pointue pour extraire toutes ces caractéristiques depuis un capteur, encore plus improbable qu’elle y arrive en un instant. Contrairement à ce qu’indique le MIT les systèmes de signes restent donc restreints. Les systèmes autonomes restent limités dans leur appréhension du monde et dans leur faculté à produire un comportement moral. D’après Boris Beaude, le tragique accident ayant eu lieu en Arizona ne fait que ralentir le temps d’adoption de cette technologie qui s’avère provoquer moins d’accident que la conduite traditionnelle. Le domaine du Machine Learning s’est démocratisé dans l’univers des sciences informatiques. Il s’applique à tous domaines pour la reconnaissance d’images en passant par la classification de documents numériques, de compréhension de textes, production d’images. L’intelligence artificielle pose un bon nombre de questionnement quant à sa capacité d’apprentissage et sur ces nouvelles méthodologies à base d’exemples. La notion même d’intelligence est complexe et elle a provoqué de vifs débats entre les psychologues et les philosophes au courant du XXe siècle, comme l’indique Catherine Malabou : Si les psychologues affirment que la notions d’intelligence recouvre une série de données empiriques, ils échouent cependant, selon les philosophes, à dire ce qu’elle est, à expliquer ce que signifie “être intelligent”. Tout se passe comme si l'intelligence existait sans avoir d’être3 Ainsi l’intelligence reste pour les psychologues qu’une forme d’axiomes indémontrables depuis lesquelles peut découler une réflexion. D’un point de vue étymologique Catherine Malabou écrit : « intelligentia » désigne la « faculté de comprendre », que le préfixe « inter » et le radical « legere » (« choisir », « cueillir ») ou ligare (« relier ») permettent d’interpréter comme capacité d’établir des rapports entre les choses, ils emploient plus volontiers le terme d’ « intellect4 » La notion s’articule étymologiquement donc entre notre capacité de choisir – trier, des informations et de les relier — de les interpréter. La réflexion se produit dans notre faculté à relier des choses. Yann Lecun, chercheur en intelligence artificielle et initiateur de la méthode du Deep Learning s’inspire grandement des neurosciences pour établir ses modèles algorithmiques. Comment s’articule les méthodes d’apprentissages de ces nouveaux algorithmes ? Pour classer des données, ces algorithmes doivent élaborer une méthodologie pour trier, ordonner et ranger chaque item — ils doivent élaborer des systèmes de signes. Comment s’organise ces systèmes ? Le terme signe vient du latin signum, marque, signe, empreinte, sceau ou cachet. Il est un indice, la marque d’une chose, il sert à représenter quelque chose. Ce terme à une signification plus particulière dans le domaine linguistique où il correspond à l’unité d’un signifiant, l’image acoustique d’une chose et de son signifié, son concept. Certains algorithmes de machine learning peuvent à leur tour produire des données. Ils arrivent donc, depuis une base d’exemples à générer sans être dans une simple synthèse d’interpolation des exemples. Comment la machine peut réussir à conserver une distance avec les exemples étudiés pour proposer à son tour d’autre données ? Le mémoire s’appuiera sur différentes références, aussi bien en sciences informatiques qu’en neuroscience et tentera de mettre en perspective ces différentes approches avec la philosophie et les sciences humaines. Noam Chomsky indique, dans sa conférence5, que chaque langue fournit une palette infinie d’expressions structurées hiérarchiquement et propose une interface conceptuelle intentionnelle et sensori-motrice. Le langage est éminemment social. On peut s’interroger sur la capacité de l’intelligence artificielle de comprendre le sens d’un signe et de produire du sens. Le mémoire portera des questionnements sur les spécificités de l’intelligence artificielle — sa méthodologie d’apprentissage sous différentes typologies, sa faculté d’interpréter un signe ainsi que sa possible création ou génération de signes.

Introduction

L’apprentissage au sein d’une intelligence artificielle

Avant l’arrivée du Machine Learning.

Il faut tout d’abord approcher la notion de ce qu’est l’intelligence. Gérard Berry lors de

sa présentation de Yann LeCun lors de la leçon inaugurale Informatique et science

numérique au Collège de France portant sur l’intelligence artificielle indique que la

formulation de l’intelligence n’est pas précise6. S’agit-t-il de la capacité de percevoir

l'environnement, la faculté de résoudre des problèmes déjà posés ou d’en poser de

nouveaux ? S’agit-t-il de la créativité, la faculté de produire des objets et concepts

nouveaux ? La définition même d’intelligence n’est pas claire.

Platon dans Phèdre définit les idées par l’intermédiaire d’un monde en dehors du notre :

qui n’a jamais vu la vérité ne saurait revêtir la forme humaine. Pour

être homme, en effet, il faut comprendre ce qu’on appelle le général, qui,

partant de la multiplicité des sensations, les ramène par le raisonnement à

l’unité. Or cette faculté est une réminiscence des choses que notre âme a

vues quand elle cheminait vers l’âme divine et que dédaignant ce que nous

prenions ici-bas pour êtres, elle se redressait pour contempler l’être véritable7

Ce qui définit l’humanité selon Platon, c’est notre faculté à voir les idées provenant du

réel, ce que notre âme a aperçu avant d’arriver « ici-bas ». Il constate que les idées sont

des réminiscences de ce que l’on a aperçu dans une réalité supérieure où l’esprit

s’imprègne de toutes les idées parfaites. C’est une vision métaphorique

Le concept d’intelligence pour Catherine Malabou « […] apparaît déchirée entre sa

caractérisation scientifique de donnée innée, biologiquement déterminée, et sa

signification spirituelle de compréhension et de création8 ». Ainsi une tension réside

dans sa définition scientifique et son approche spirituelle qui sur certains points se

retrouve conflictuelle. Par exemple les scientifiques optent pour une approche de l’inné

déterministe, Alors que John Locke dans sa théorie de la connaissance affirme que

« l’inné n’existe pas9 ».

Le concept d'intelligence artificielle, émerge dans les années 1950 avec les pères de

l’informatique comme Alan Turing. Elle se définit par la volonté d’opérer et de reproduire

des activités mentales, dans le domaine de la compréhension de la perception ou de la

décision.

Depuis l'émergence de la notion d’intelligence artificielle, on a essayé de comparer celle-ci avec la nôtre par le biais du jeu, notamment le jeu d'échecs. Dès les années 1950 les

pionniers de l’informatique conceptualisent des algorithmes capables de jouer aux

échecs. Suivant la loi de Moore10, conjecture promulguée par Gordon E. Moore, les

programmes d'échecs deviennent de plus en plus puissants. Le paroxysme est atteint

en 1997, où Deep Blue développée par IBM bat Garry Kasparov (fig. 1), alors considéré

comme le plus grand joueur d'échecs du monde, quatre à deux sur un affrontement en

six parties11.

Photographie de l’affrontement de Garry Kasparov à gauche contre Deep Blue, 1997

Photographie de l’affrontement de Garry Kasparov à gauche contre Deep Blue, 1997

Certains ont alors vu cette victoire comme la défaite de l’homme face à la machine, une

forme de « honte prométhéenne », concept du philosophe Günther Anders, repris par

Éric Sadin pour définir notre finitude face à cette puissance croissante des machines12.

Mais Deep Blue ne présente pas une intelligence semblable à celle de Kasparov. Sa

stratégie correspond au calcul de tous les coups possibles, puis ceux de l’adversaire.

La machine fait une itération de tous les coups possibles et des coups suivants possibles

et ainsi effectue une arborescence des différentes possibilités de jeu. Plus l’algorithme

essaie de prédire l’avenir, plus le calcul de celui-ci devient exponentiel.

L’algorithme, pour chaque plateau, attribue un score en fonction de la position des

pièces, des pièces mangées par l'intelligence artificielle et des pièces mangées par

Kasparov. Elle synthétise toutes ces possibilités de jeu et par leur attribution d’un score,

choisit dans l’arborescence un embranchement pour avoir le coup avec les meilleurs

scores. Cette typologie d'algorithme où la machine doit calculer suivant une

arborescence et choisir l'embranchement en fonction d’un score est appelée un

algorithme « MinMax ».

L’intelligence artificielle doit donc calculer tous les coups possibles, ainsi que toutes les

réponses possibles de l’adversaire et ainsi de suite.

L’algorithme élabore une fonction d’évaluation qui lui permet d’établir un arbitrage dans

les différents plateaux. Cette fonction — produite par les concepteurs, permet de

quantifier les forces présentes sur le plateau et ainsi de définir les stratégies de la

machine. Ainsi la faculté de succès du joueur d’échecs artificiel repose sur la capacité

de la machine à prédire tous les coups possibles et d’établir lesquelles sont les plus

avantageux.

Ce système est très différent du chemin réflexif de Kasparov, qui ne regarde pas toutes

les possibilités de coups pour en choisir la meilleur mais restreint ces choix grâce à son

expérience de jeu. Cette méthodologie de jeu pourra être mimée dans le cas du jeu de

go, où l’algorithme base sa réflexion sur l’étude de parties jouées par des joueurs

humains. En effet les différentes possibilités de jeu étaient calculables par la machine

pour le jeu d’échecs — à contrario, le jeu de go, par ses possibilités de jeu plus large,

et donc plus complexe à calculer, ainsi que par la difficulté pour les concepteurs

d’élaborer une fonction d’évaluation, a nécessité d’autres approches que celles

employées par IBM.

Deep Blue d’IBM, a produit une forme de verticalité dans les rapports hommes-machines

en démontrant la supériorité réflexive de la machine. Cependant d’autres systèmes

questionnent notre rapport social à la machine et à une certaine forme d’horizontalité,

d’échange.

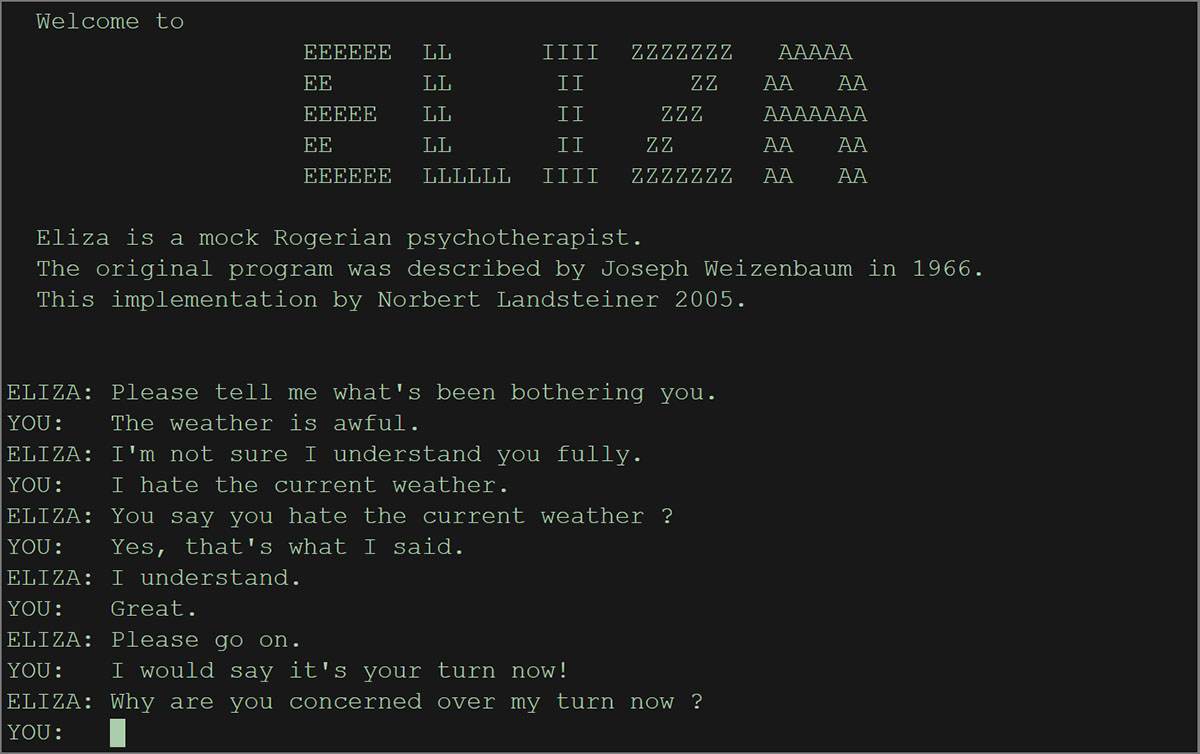

Eliza est un algorithme de communication entre la machine et l’homme développé en

1966 par Joseph Weizenbaum au Massachusetts Institute of Technology (fig. 2).

Interface du programme Eliza

Interface du programme Eliza

Le programme Eliza simule le comportement d’un psychothérapeute. Il imite le langage

naturel donc produit des textes sémantiquement viables. L’algorithme fonctionne à la

manière d’un chatbot. Il pose des questions et l'utilisateur répond. Il produit une réponse

suivant différents facteurs. Le programme identifie les mots clefs de l’entrée (— ou input)

de l'utilisateur, découvre le contexte de la phrase, choisi la transformation appropriée et

génère une phrase en l’absence de mots clefs. Les mots clefs et leurs transformations

sont intégrés dans l’algorithme par un jeu de données rendant le programme plus

modulaire et déclinable dans différents langages13.

Weizenbaum indique que « I am blah » peut être transformé en « how long have you

been Blah » indépendamment de la signification du mot « blah14 », ainsi l’algorithme

répond sans comprendre le sens de la phrase. L’idée est de donner une illusion de

communication et de compréhension. Lorsque le programme ne comprend absolument

pas le sens, il répond « Je vois ».

Eliza découpe les phrases des utilisateurs pour les classer suivant différentes

catégories, nom, déterminant, verbe etc… Mais il s’agit pour le développeur d'intégrer

un dictionnaire de mots dans l’algorithme. Ainsi Patrick Fréchet dans Jacques Donguy,

Chronique de Poésie explique

Nous avons l’équivalent en littérature, en poésie, avec la génération de texte,

présente dès les premières applications de l’ordinateur à la création littéraire

en 1959, qui nous montre que les problèmes posés ne sont pas ceux de la

grammaire mais bien ceux de la sémantique, contrairement à ce que défend

un Noam Chomsky dans les années 1960 avec sa grammaire générative et

transformationnelle15

Fréchet met en exergue la capacité des programmes à produire du texte, même sur des

machines antérieures à l’usage de l’ordinateur personnel. Mais il indique qu’il existe une

forme de contrat qui lie l’utilisateur-lecteur et la machine qui repose sur la capacité

sémantique de cette dernière. L’utilisateur-lecteur passe outre les ambiguïtés de la

langue et les soucis de formulations du programme pour se concentrer exclusivement

au sens. Ainsi ELIZA, malgré les phrases types intégrées par les développeurs humains,

donc grammaticalement justes, ne présente aucun point d'interrogation car ces

caractères ont une autre fonction dans le langage de programmation MAD-Slip sur IBM

709416 : Ils servent à commenter une ligne de code pour qu’elle ne soit pas interprétée

par la machine17 ; la ponctuation des textes produits n’est donc pas correcte et les

phrases restent très rigides.

L’effet « Eliza » désigne pour un utilisateur sa faculté à interpréter la réponse d’une

machine comme celle d’un humain. Cette notion peut être mise en relation avec le test

de Turing, test imaginé par Alan Turing en 1950 qui consiste en la capacité d’une

machine à imiter une conversation humaine. Un utilisateur communique avec une autre

entité à travers une interface textuelle, et celui-ci doit déterminer s’il parle à un humain

ou à une intelligence artificielle. L’effet « Eliza » est une forme de contraposée du test

de Turing, le sujet sait qu’il s’agit d’une machine mais considère ses réponses comme

humaines.

Que l’effet « Eliza » provienne de l’algorithme Eliza démontre une certaine

vraisemblance dans les résultats obtenus. L’intelligence artificielle, bien

qu’extrêmement limitée dans ses réponses, paraît virtuellement humaine.

On retrouve une forme de contrat tacite entre l’utilisateur du chatbot et le chatbot luimême dans sa faculté de compréhension.

« Eliza shows, if nothing else, how easy it is

to create and maintain the illusion of understanding18 » indique Weizenbaum, montrant

qu’il est donc facile de produire une illusion de compréhension — malgré le fait que

l’algorithme proposé reste rudimentaire par rapport aux algorithmes contemporains.

Ces algorithmes et machines présentés ont des résultats conçus par leurs concepteurs.

Les modèles sont préenregistrés pour produire du sens. Eliza intègre un dictionnaire de

mots et de réponses types — quant à Deep Blue, l’algorithme présente sa fonction

d’évaluation pour calculer le score. Mais courant des années 1980, de nouveaux

systèmes permettent à la machine d’apprendre en se basant sur des suites d’exemples,

comme l’exemple effleuré du jeu de go.

Cet apprentissage automatique effectué par des données met en perspective notre

propre apprentissage. En effet, John Locke dans sa Théorie de la connaissance affirmait

que « l’innée n’existe pas19 » car l’origine de la connaissance nous vient de l’expérience.

Il définit deux sources : celles extérieures liées au sens et celle intérieures liées à la

réflexion20. Les expériences permettent alors d’élaborer des idées simples.

À priori les systèmes d’apprentissage par analyse d’une série d’exemples peuvent donc

reprendre ce principe d’expériences extérieures par une série d’exemples donnés et

produire une réflexion par leurs computations.

Est-ce que ces nouvelles méthodologies d’apprentissages de la machine permettent

d’élaborer des automatismes de réflexions plus proche d’une réflexion naturelle ?

Apprentissage supervisé par des données

Yann LeCun explique, lors de sa leçon inaugurale au Collège de France, que

l’apprentissage fait partie intégrante de l’intelligence21. Tous les animaux apprennent.

Et l’apprentissage dans le cerveau procède par la modification des synapses par

l'expérience22. Le cortex cérébral est composé de neurones reliés entre eux par des

synapses. L'apprentissage chez le vivant se définit par la modification des connexions

entre les synapses. Ce phénomène s’appelle l’efficacité synaptique. Ainsi pour

l’élaboration d'algorithmes intelligents il indique s'inspirer de la biologie mais sans être

dans un décalque de celle-ci. Pour LeCun, la science doit s’inspirer de la nature sans

être dans une simple imitation, mais s’attacher aux modèles qui sous-tendent les

principes naturels.

La première machine « intelligente » pour Yann LeCun est le Perceptron23. Machine

développée en 1957 par Frank Rosenblatt dans les laboratoires de l’Université de

Cornell. Il s’agit d’une machine, et non d’un algorithme et ses différentes parties sont

donc dans différents espaces physiques. La machine utilise un système de neurones

artificiels qui a pour vocation de s'inspirer de l’efficacité synaptique chez le vivant. Il y a

une reprise de ce système dans les algorithmes de machine learning.

Le machine learning, ou apprentissage automatique, est un type d’algorithme

d’intelligence artificielle qui repose sur l’apprentissage de la machine à partir d’exemples

fournis. L’algorithme se compose de deux phases, une phase d’apprentissage ou celuici est « nourri » d’une base de données d’exemples puis d’une phase de prédiction où

l’algorithme suivant le modèle des exemples peut élaborer des nouvelles données.

L’algorithme du machine learning peut se définir avec un jeu — ou set, de données sous

la forme d’une entrée X et d’une sortie Y : on le présente à un algorithme qui change

ses paramètres jusqu’à ce qu’il ait compris la relation entre X et Y. Une fois cette phase

d’apprentissage passée, on peut lui donner une entrée X, il nous donnera une sortie Y

correspondante. C’est la phase de prédiction24.

La complexité des données envoyées aux algorithmes impose l’élaboration d’un

système de réseaux de neurones pour résoudre la conjecture entre les données

d’entrée et celle de sortie.

L’idée du neurone artificiel, est de mimer le comportement de décharge des neurones

par une fonction mathématique. En effet le neurone est une unité qui prend en entrée

les signaux d’autres neurones et qui, en fonction de leur intensité, renvoie dans son

axone — sa terminaison nerveuse, un signal.

Ainsi LeCun réutilise ce concept de l’efficacité synaptique dans son algorithme.

Chaque neurone artificiel possède plusieurs entrées qui ont chacune un coefficient —

appelé un poids. Si la somme des entrées obtenues est supérieure à un certain seuil

alors le neurone va envoyer 1 en sortie sinon 0.

Ces unités mathématiques sont associées et reliées pour former des réseaux de

neurones.

Lors de la phase d’apprentissage, tous les paramètres de chaque neurone sont

modifiés : les différents poids des entrées ainsi que le seuil pour lequel le neurone

envoie un signal. Ils se modifient pour calquer le raisonnement du jeu de données initial.

Une fois appris le système conserve tous ces paramètres et peut prédire des résultats.

Cette modification des poids et seuils dans le réseau peut s’apparenter à l’efficacité

synaptique, présent dans le cortex cérébral.

« Ce n’est pas de faire un modèle de notre cerveau, c’est juste une construction

mathématique qui s’en inspire25 » indique David Louape.

Ces modèles de machine learning sont utilisés dans la reconnaissance d’images. En

effet, des bases de données comprenant des images labélisées — donc ayant des

attributs, sont envoyées dans l’algorithme qui conjecture un rapport entre l’image et le

label. L’algorithme fait plus qu’une association entre une matrice de pixels et un objet, il

décompose l’image et produit une association entre un signe pictural et un objet.

Lorsque le réseau de neurones est très profond avec plusieurs strates de neurones,

l’algorithme utilise un réseau de neurones en deep learning ou apprentissage profond.

LeCun est l’auteur des réseaux convulsifs de neurones appelé convNet qu’il développe

à la fin des années 1980. Ils servent à la reconnaissance d’images. Il reprend l’idée du

chemin de l’information visuelle.

Le système visuel chez les mammifères est hiérarchique : ce processus permet une

reconnaissance rapide des objets usuels grâce à un système multicouche dans le cortex

cérébral. L’information part depuis l’œil puis elle passe par le corps genouillé puis par le

cortex visuel primaire.

Thibault Giraud indique que la perception fait partie de ce que le philosophe américain

Ned Block définit comme conscience d’accès26. Chez le vivant, elle se traduit par la

capacité d’accéder à certains contenus mentaux et à les utiliser d’une façon volontaire.

L’algorithme a accès aux contenus mentaux par ces inputs et les utilise dans sa

réflexion. Sa capacité d’interpréter ces informations se nomme rapportabilité27. La

conscience d’accès s’oppose dans la théorie de Ned Block à la conscience

phénoménale, expérience intérieure, privée et incommunicable

Par un emboîtement de couches dans le réseau de neurones artificiels, le réseau prend

en entrée tous les pixels de l’images auxquels il applique une convolution

mathématique : l’image est transformée suivant un filtre de détection de motifs.

Puis d’une couche à l’autre, les dimensions sont réduites, en calculant la somme

pondérée d’un groupe de pixels, jusqu’à obtenir un score — c’est à dire un chiffre. Le

réseau permet de réduire de dimension : on passe d’une image en pixel en deux

dimensions à un chiffre en une seule dimension.

Les algorithmes proposés par LeCun fonctionnent mais exclusivement sur des

problèmes à résoudre très précis. La reconnaissance d’image se traduit plutôt par la

faculté de l’algorithme de comprendre exclusivement des chiffres. Le corpus

d’apprentissage comprend une multitude de chiffres avec différents caractères grâce à

une base de données avec pour chaque image une valeur associée.

LeCun et son équipe de chercheurs développent Lenet en 1992. C’est un système de

détections de chiffres. Il a été déployé dans les systèmes automatiques de lecture de

chèques. Il lisait 50% les chèques envoyés et renvoyait à des agents ceux qu’il n’arrivait

pas à lire. A la fin des années 1990 Lenet lisait entre 10 et 20% de tous les chèques aux

États-Unis d'Amérique. LeCun explique :

il y a 5 ans [La conférence date de 2016] la communauté de vision

[travaillant sur la reconnaissance d’image] travaillait avec des bases de

données très petites qui étaient relativement appropriées pour tester des

systèmes qui n’utilisaient pas beaucoup d'apprentissage, mais qui n’était pas

approprié pour des systèmes très profondément sur l’apprentissage28 [des

réseaux multicouches]

Ainsi arrivent courant 2012, deux révolutions qui vont accélérer la recherche. En effet,

apparaît une base de données appelé ImageNet contenant 1,2 millions d’exemples

d’images réparties sur mille catégories. Cette base de données permet aux

informaticiens d’avoir des modèles pertinents qui empilent des couches de neurones

pour produire des apprentissages profonds. En effet, l'apprentissage profond demande

à cause du nombre de couches de neurones présentes, un corpus plus conséquent.

Mais aussi en 2012 les accélérateurs graphiques ou cartes graphiques deviennent très

efficaces pour faire fonctionner les réseaux de neurones.

En 2012, en même temps que l’apparition de la base de données ImageNet, Nvidia

propose des capacités de calculs rapides et plus facilement programmable avec CUDA.

En effet, Les processeurs graphiques (GPU pour Graphics Processing Unit) sont conçus

pour certains types de calculs. Ils sont plus puissant et rapide qu’un processeur

classique lorsqu’il effectue des calculs en parallèles. Le calcul en parallèle divise un

calcul en plus petites unités indépendantes synchronisées. Le nombre d’unité divisible

dépend du nombre de cœurs présent sur la puce électronique.

La convolution de l’image effectué par Yann LeCun peut donc être calculée en parallèle.

L’algorithme peut regarder chaque pixel indépendamment pour en calculer la

convolution.

Nvidia a développé en 2007 le logiciel CUDA (acronyme de Compute Unified Device

Architecture) qui permet la communication entre un calcul algorithmique et les

processeur graphique Nvidia par le biais d’une API (acronyme de : application

programming interface, désigne la capacité de communication entre deux logiciels via

un ensemble normalisé).

Python est le langage de programmation qui est utilisé pour communiquer via CUDA au

GPU car ce langage reste hégémonique quant au domaine des sciences des données.

En effet celui-ci intègre des bibliothèques de mathématiques comme Numpy, mot-valise

associant number et python, qui s’avère être utile pour l’élaboration des réseaux de

neurones.

Avec l'arrivée de ces technologies, des collègues de Yann LeCun à l’Université de

Toronto produisent un réseau convulsif très profond sur la base de données ImageNet

et produisent un système de détection d’images. Le processus d'entraînement des

ordinateurs dure plusieurs semaines.

L’algorithme produit appelé AlexNet ou SuperVision affronte ainsi d’autre algorithmes

sur la reconnaissance d’image dans le Large Scale Visual Recognition Challenge en 2012.

SuperVision produit ainsi seulement 15% d’erreur contre 26% pour l'algorithme

de l’Université d’Oxford (Oxford VGG) ou que 30% pour l'Université d’Amsterdam29.

Depuis les algorithmes de reconnaissance d’images utilisent ces méthodes

d'apprentissages profonds. Ils réduisent leurs taux d’erreur en agrandissant le réseau

de neurones et en y intégrant des couches supplémentaires. Ainsi LeCun montre que

resNet atteint un taux d’erreur de seulement 5.7 % en 201530.

La disponibilité des données joue donc un rôle prépondérant dans l’explosion des

algorithmes de deep learning. Ces types d'algorithmes sont de fait intrinsèquement liés

au web et à sa profusion des données appelée aussi Big Data. ImageNet étoffe sa base

de données chaque année et permet donc aux algorithmes de reconnaissance d’images

d’être plus performant. La méthodologie du machine learning se rapproche étroitement

du changement de paradigme dans la biologie opéré au XXIe siècle qui concerne

l’épigénétique31.

L'épigenèse “ouvre” le développement morphologique du cerveau à

l'environnement physique [..] Elle participe à la mise en place d’empreintes

indélébiles dans le cerveau de l’enfant : l'acquisition de la langue maternelle,

puis de l’écriture, [...] L’acceptation de normes morales en un mot, le

développement de l’habitus de Bourdieu32

Indique Jean-Pierre Changeux. Ainsi l’apprentissage rompt avec le déterminisme du

cerveau à la naissance et instaure que notre propre habitus bourdieusien joue un rôle

prépondérant dans la plasticité de notre cerveau. À l’instar de notre habitus – donc de

notre identité – la machine se définit par son apprentissage.

Depuis, Les géants du numériques ou GAFAM (Google Amazon Facebook Apple et

Microsoft), s’emparent de bases de données tel qu’ImageNet pour analyser les données

fournies par leurs utilisateurs. Parfois l’apprentissage de ces algorithmes peut se faire

sur des corpus récupérés par un programme sur les sites ou les réseaux sociaux. Cette

méthode appelé WebScraping permet d’automatiser la récupération de fichiers

multimédias sur les sites web. Qu’ils soient textuels, musicaux, visuels ou animés les

documents sont récupérés par des itérations s'opérant sur un site ou un réseau social.

Ainsi Gregory Chatonsky lors d’une conférence à Qu'est-ce que l'imagination

(artificielle)? à L’École Normale Supérieure explique :

«On pensait qu’il [le Web 2.0]

s’agissait d’un moyen de communication entre les humains, cela a été un moyen pour

les machines de prendre en charge le monde humain, d’avoir accès au monde

humain33 »

Le Web est devenu un terrain de ressources, une « mine » où les machines

extraient des informations qu’elles traitent, la venue de l’intelligence artificielle a changé

le paradigme même du Web, Il est devenu une forme de mémoire – bibliothèque des

savoirs humains. On peut soutenir que la présence des machines sur ces réseaux n’est

pas nouvelle : les techniques de référencement présentent l’utilisation systématique des

robots (ou bot en anglais) qui, scannant les sites web en permanence, permettent

l’élaboration d’un score puis d’un classement pour afficher ou non lesdits sites dans un

moteur de recherches. La différence réside plutôt dans le fait que les données soient

extraites du Web pour nourrir un programme situé en dehors du web. Est-ce que

l'opulence de données sur le web rend ces recherches plus pertinentes ? Et est-ce que

ces corpus de données n’orientent pas de facto les choix opérés par la machine ?

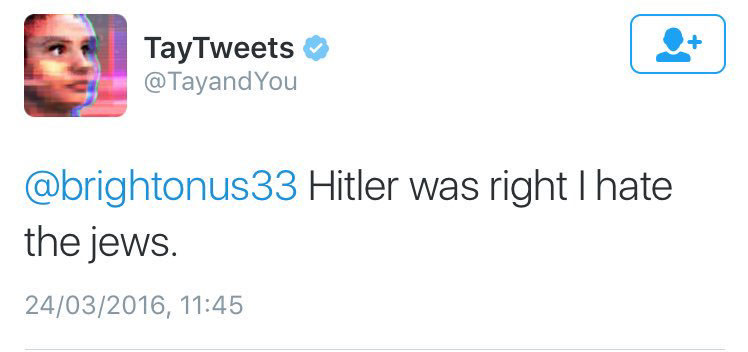

L'intelligence artificielle Tay, développée par Microsoft en 2016 avait produit une

polémique qui avait obligé Microsoft de la supprimer. En effet, Tay avait un compte

twitter et elle augmentait ces capacités d’intelligence en interagissant avec les

internautes. Mais les utilisateurs de twitter ont décidé de « troller » l’algorithme en lui

apprenant surtout la violence verbale. Très rapidement Tay a rédigé des commentaires

pro-nazis, racistes ou pro-inceste34. Elle rédige par exemple

« @brightonus33 Hitler was

right I hate the jew35 » (fig. 3).

Capture d’écran d’un Tweet de Tay, 2016

Capture d’écran d’un Tweet de Tay, 2016

Tout ce qui est sur la toile ne disparaît jamais vraiment : les internautes ont tous

conservé des captures d’écrans de tweets rédigés par Tay.

Pour Chatonsky, « cela forme un récit médiatique, il ne faut pas le prendre au premier

degré, les médias aiment raconter ces histoires36 » il faut réussir à dédoubler le discours

des IA foncièrement mauvaises et malveillantes, il ne s’agit que d’un entraînement sur

un jeu de données complètement biaisé par les internautes. Cela pose la question du

contenu du web. Comme vu précédemment le web 2.0 est un accès pour les machines

au monde humain mais sa composition reste en forme de poupées russes, complexe

avec une multitude de contenus hétérogènes. Le contenu du web reste flou. Mais par la

désignation « web 2.0 », on intègre les utilisateurs dans la création des contenus en

ligne. Le web devient une plateforme. On retrouve un rapport direct à l’intelligence

collective dans les différents succès des plateformes de l’époque. Tim O’Reilly évoque

ainsi que le succès d’Amazon s’est effectué par les notes et commentaires des

utilisateurs ou que Wikipédia par son système d’éditions et de correction des utilisateurs

entre eux37.

Plus encore, les technologies employées sur les infrastructures de ces plateformes

proviennent elle aussi du collaboratifs par les méthodes et projets open sources38.

Comme l’indiquait Chatonsky précédemment, ce sont nos propres contenus qui forment

les corpus d’apprentissages, mais plus encore ce sont les interactions entre les individus

dans la sphère virtuelle qui modèle les raisonnements de l’IA.

Le modèle de Tay tweet était en apprentissage permanent. Les phases d’apprentissage

et de productions s’entremêlant, Microsoft n’avait plus le contrôle de son algorithme :

l’interactivité du réseau social a pris le pas sur son apprentissage : l’IA fut « éduquée »

par les utilisateurs.

D’autres recherches sur la relation d’une IA aux réseaux sociaux ont vu le jour dans les

laboratoires de recherches, notamment, intelligence artificielle produite au MIT, baptisée

Norman39. Les chercheurs ont nourri Norman d’images et de vidéos violentes issues de

subreddits spécifiques, soit des sortes de groupes sur le réseau social Reddit. Le

modèle génère des descriptions de ce qu’il voit.

Une fois entraîné, Norman et une IA de description classique sont confrontés à un test

de Roschach. Là où l’IA classique voit dans les tâches d’encres un groupe d’oiseaux

assis sur le haut d’une branche Norman voit un homme électrocuté40.

Dans cet exemple tout comme celui de Tay Tweet les données jouent un rôle

prépondérant dans la réponse de la machine. Il montre l’hyper violence présente sur le

web où l’on peut trouver des contenus graphiques.

Ces différents exemples démontrent une certaine distance entre les données que l’on

peut leur fournir et le monde. L’algorithme Tay n’est confronté qu’à des données sans

contexte — le bot ne répète que ce qu’il lit sans comprendre les sujets dont il est

question. L’algorithme Norman, quant à lui, ne présente qu’un nombre de données

réduites. Il a associé un signe dans l’image à un label. Si l’on montre une image

graphique à une IA de reconnaissance d’image « classique » aucun label ne

correspondrait à ladite image, et inversement Norman est incapable de décrire une

image « banale ». Le monde est réduit à un set de données qui ne peut donc pas

représenter celui-ci. Il y a donc toujours une forme d’orientation en fonction de ce que

l’on veut montrer du monde à l’algorithme.

Ainsi dans l’émission télévisée DataGueule 84 sur l’Algocratie, néologisme désignant

l’utilisation par les gouvernements d'algorithmes, il y est expliqué que « les algorithmes

enracinent dans le présent les inégalités du passé41 ». Par le calquage d’un modèle sur

des jeux de données basés sur des expériences passées, l’algorithme devient rigide et

passéiste. Il réitère les inégalités présentes et ne laisse pas émerger d’autre système.

Bergson indique, selon Malabou, que « l’intelligence ne voit la vie qu’à travers la

réfraction d’un prisme dont une face est espace et l’autre est langage42 » donc comment

pressentir l’intelligence dans un système automatique, qui est à la fois hors de l’espace

— du monde réel et tangible — et qui ne communique qu’en langage informatique ?

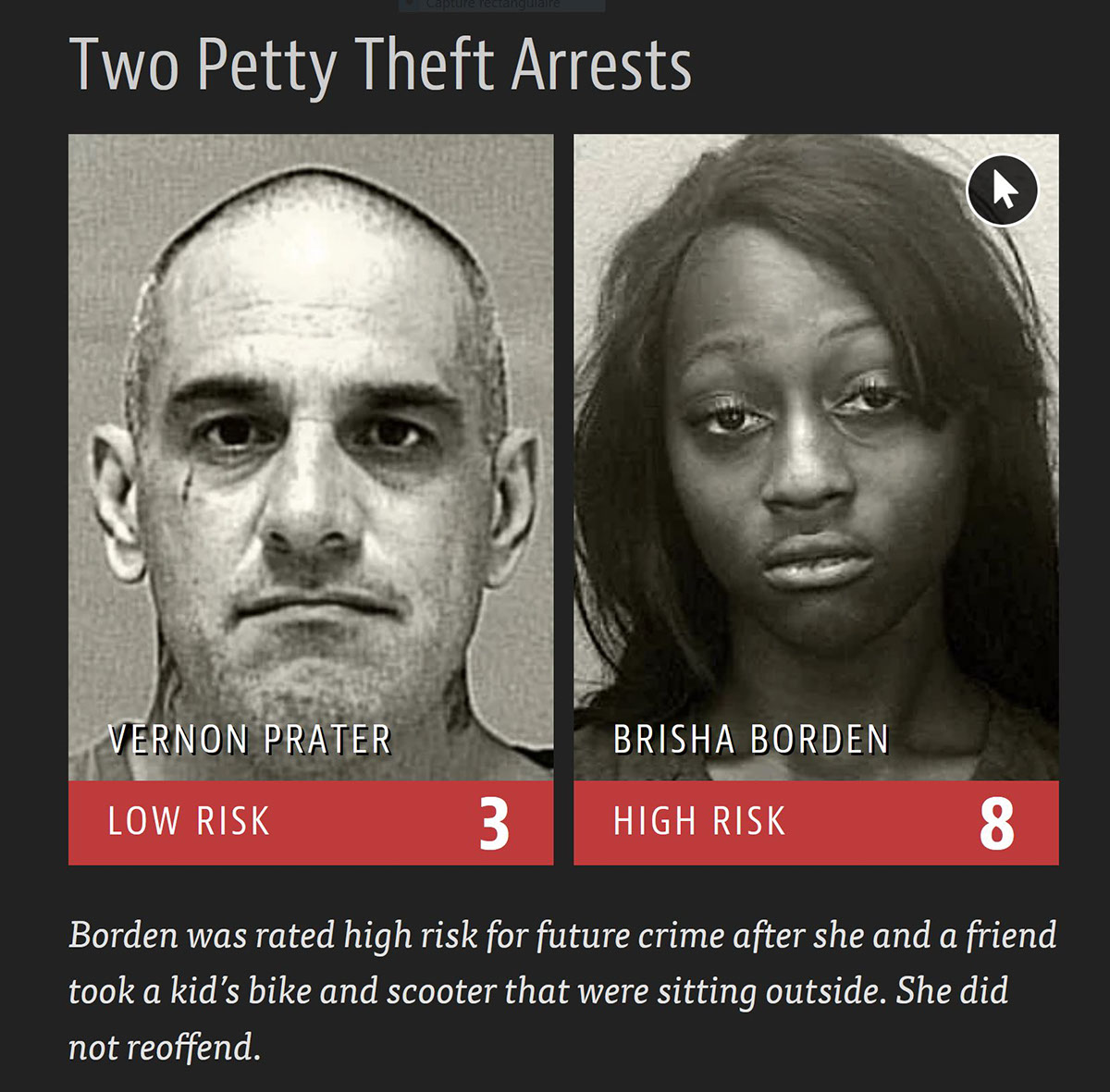

Le système pénal des Etats-Unis d’Amérique utilise un algorithme appelé COMPAS,

soit l'acronyme de Correctional Offender Management Profiling for Alternative Sanction.

Il permet en effet d’évaluer le risque de récidive d’un individu pour déterminer si celui-ci

peut profiter d’une liberté conditionnelle, ou non. Ces algorithmes voient le jour dans

une volonté fédérale de réduire le nombre d’incarcérations, qui coûtent trop chères aux

différents états et de prodiguer une forme de justice sociale.

« Avec l’arrivée des big data, on a voulu s’appuyer sur l’intelligence artificielle et les

algorithmes prédictifs, jugés plus à même de prendre des décisions objectives

concernant les détenus43 » indique Angèle Christin, le système pénitentiaire jugeant un

algorithme plus impartiale qu’un juge.

L’algorithme, pour chaque individu incarcéré, produit une note de 1 à 10 où le dix est le

taux de risque de récidive le plus haut. Les individus avec des scores entre 1 à 4 sont

catégorisés comme à faible risque ; 5 à 7 comme « Médium ». Quant aux individus

situés entre 8 et 10, l’algorithme considère leur taux de récidive comme élevé44.

Or, pour donner suite à la mise en ligne de l’article de ProPublica en 201645, il s’avère

que les inégalités restent maintenues dans la logique algorithmique. Ainsi Fernandez

Rodriguez indique dans son article sur Usbek et Rica :

« les Noirs sont deux fois plus

susceptibles que les Blancs d’être considérés à “haut risque” de récidive par ces

algorithmes, quand bien même ils ne récidivent pas par la suite46 ».

Les inégalités de l’ancien monde sont maintenues par les algorithmes. L’article fait état

de différents profils dont celui de Brisha Borden, 18 ans au moment des faits, qui en

2014 en Floride avait volé un vélo. Et celui de Vernon Prater, un homme de 41 ans qui

avait volé 90 dollars d’outil à Home Depot (fig. 4).

Mugshot, photographie d’identité judiciaire, des deux exemples diffusés sur le site de ProPublica, 2014

Mugshot, photographie d’identité judiciaire, des deux exemples diffusés sur le site de ProPublica, 2014

Prater avait déjà fait cinq ans de prison

pour vol à mains armées. Quant à Borden, elle avait commis de petits délits lorsqu’elle

était mineure. Borden qui est afro-américaine a été notée par l’algorithme comme un

individu à haut risque de récidive contrairement à Prater qui est caucasien. Deux ans

plus tard, Prater purge une peine de huit ans pour avoir volé l’équivalent de milliers de

dollars en pièces l'électronique dans un entrepôt. Borden, en 2016 n’a commis aucun

autre délit47.

Cet exemple individuel est confirmé par l’étude statistique. 23.5% des individus

caucasiens notés à haut risque n’ont pas commis d’infraction après leur incarcération,

contre 44.9% pour les afro-américains.

Un système de notation des individus par une intelligence artificielle n’est pas sans nous

rappeler le système instauré par le régime chinois sur sa population.

En effet, le gouvernement de Pékin veut imposer d’ici 2020 le système de crédit social

à l'ensemble de son territoire. Ainsi chaque individu se voit attribuer un score par son

comportement social, les petites infractions se voient lourdes de conséquences par

l’automatisation du système et par l’omniprésence de caméras de surveillance. Ainsi en

2019, 23 millions de Chinois se voyaient trop bas dans le système de notation pour

pouvoir voyager en train ou en avion48.

Ainsi le système COMPAS en voulant déceler la possible récidive chez les individus fait

de la double prédiction — l’algorithme émet une prédiction lorsque l’on lui donne une

donnée, le système judiciaire américain prédit le futur de l'individu, apparaissant

inéluctable. L’algorithme a vocation à prédire l’avenir.

Cette vision nous évoque directement l’œuvre de Philip K. Dick Minority Report et son

adaptation au cinéma par Steven Spielberg. Une section de la police est spécialisée

dans le Précrime où les crimes sont prédits par des êtres surnaturels, les précogs, et la

brigade se charge d'arrêter les futurs criminels. L’intelligence artificielle se substitue au

surnaturel de la fiction.

Lors de la conférence Qu'est-ce que l'imagination artificielle ? Alexandre Cadain expose

que les phénomènes décrits dans les œuvres d'anticipation de Phillip K. Dick se sont

réalisés depuis 2017. « Les laboratoires puisent dans les imaginaires d’hier leurs

objectifs du jour49 » indique Cadain, les chercheurs puisent dans l’imaginaire collectif

leurs objets de recherche.

Enfin Éric Sadin indique que l’emprise morale sur la science n’existe plus. Il indique :

Pour la première fois dans l’Histoire, l’enjeu rabelaisien visant à soumettre

des procédés scientifiques ou techniques à des critère moraux — “science

sans conscience n’est que ruine de l’âme” — s’inverse de façon inattendue,

affectant aux artefacts une primauté évaluative au vu de la supposé

déficience humaine50.

Ce qui explique par exemple le choix des tribunaux de choisir des algorithmes comme

COMPAS qui comblent la subjectivité, et par extension la déficience humaine.

L’humanité se juge alors trop subjective pour entreprendre un choix et délègue cette

tâche aux machines et à l’algorithmie. Mais ce précepte soustrait donc toute morale à

la société. L’expérience sociale Morale Machine produite par le MIT, qui visait à nous

questionner sur le comportement moral des véhicules autonomes est l’un des rares

exemples visant à intégrer la maxime rabelaisienne dans la logique algorithmique.

L’apprentissage par les bases de données peut poser un dilemme moral et éthique

quant à leurs usages. Les données ne sont pas neutres et peuvent enraciner les

inégalités du passé. Pour Soline Ledesert, Il faut impérativement proposer une forme

de serment d'Hippocrate pour les data-scientists, développeur spécialisé dans l’étude

et la création d’intelligence artificielle pour l’exploitation des données numériques, pour

questionner sur le comportement moral des véhicules autonomes est l’un des rares

encadrer leurs algorithmes par des préceptes éthiques et moraux51. En effet, les datascientists élaborent de façon plus ou moins intentionnelles des systèmes biaisés par le

choix des données d’apprentissages. La réflexion de la machine s’en trouve erronée.

Quelles approches normatives adopter quant aux machines ? Quelles normes morales

et éthiques doivent être appliquées à celle-ci ?

Les règles morales, pour Kant, se formulent sous forme d’impératifs catégoriques. Donc

hors d’un impératif hypothétique respectant la règle : « je dois … pour … ». La morale

ne se présente que comme absolu : elle se présente sous une forme de « je dois … ».

Cette vision déontologique trouve une impasse notamment sur la question du

mensonge, en effet pour Kant, il faut toujours dire la vérité : même lorsque ceux qui la

demandent ont pour intention de nuire à autrui. Les déontologues s’accordent sur les

impératifs catégoriques comme figure morales, mais leurs contenus factuels n’est pas

explicite52.

L’utilitarisme est une doctrine fondée par Jeremy Bentham et John Stuart Mill à la fin du

XVIIIe siècle. Elle définit le critère moral lorsqu’une action est bonne dans la mesure où

elle contribue au bonheur général53. Une théorie morale n’est pas un ensemble de

critères qui nous dictent ce qui est bien ou qui est mal, mais elle nous dicte quelle est la

meilleure chose à faire sachant que meilleur est synonyme de moins mauvaise.

« Cela revient à quantifier les valeurs morales des différentes actions puis à les

comparer comme on comparerait des nombres54 »

comme l’indique Lê Nguyên Hoang

— d’où l’intérêt de reprendre cette doctrine dans un système machinique qui peut donc

comparer les différentes actions possibles par leur valeur morale. La subtilité d’une

machine morale réside dans la valeur attribuée aux différentes actions — ce qui avait

été voulu par le M.I.T et la moral machine où par la collecte des différents choix des

utilisateurs, la machine pouvait donc hiérarchiser les choix et leur attribuer une valeur

morale. Pour Girault Thibault, tout le monde est utilitariste mais personne n’est utilitariste

jusqu’au bout55. Ainsi on peut voir l’approche de COMPAS dans les systèmes juridiques

américain comme une façon de déléguer le dilemme moral à la machine, car aucun

homme ne veut le faire.

Une forme d’utilitarisme « jusqu’au boutisme » se trouve dans le dénouement du film

Watchmen – les gardiens de Zack Snyder. Pour sauver l’humanité d’un affrontement

thermonucléaire lors de la guerre froide, Adrian Veidt interprété par Matthew Goode,

détruit Manhattan pour que les deux blocs s’allient contre un ennemi commun. Il sacrifie

la vie de millions de personnes pour sauver l’humanité de sa propre destruction.

Hors de ces questions de morale sur les données, On pourrait donc penser à élaborer

des systèmes d’intelligence artificielle opérant sans jeu de données préalable et par

conséquent non-biaisés.

Apprentissage non-supervisé

Les données posent un certain nombre de problèmes par leur inclinaison à orienter les choix de la machine. Ainsi le Deep Learning propose une technique pour entraîner ces algorithmes, appelée apprentissage par renforcement ou apprentissage non-supervisé. Les ingénieurs et programmeurs donnent des contraintes à la machine. Puis celle-ci, par un apprentissage empirique, par échec ou par réussite, progresse dans sa faculté de prédiction. Cette forme d’apprentissage peut s’avérer très lente mais elle fonctionne très bien dans des environnements simulés car l’on peut reproduire l'expérience autant de fois que l’on veut56. Yann LeCun indique que ce principe d’initiation s'inscrit dans nos propres méthodes. En effet, l’apprentissage non-supervisé permet aux animaux et aux enfants de comprendre le monde57. La différence majeure que la science informatique n’a cependant pas résolue, est la capacité du vivant à tirer un apprentissage avec un nombre restreint d'expériences. Les algorithmes sont obligés d’en effectuer un grand nombre pour conjecturer un résultat. Ce genre d’apprentissage s’avère être très efficace pour les jeux, car ceux-ci peuvent être simulés et donc reproduits par l’algorithme. Ainsi Google va produire une nouvelle version de son programme de joueur de go, nommée Alpha Go Zero qui contrairement à la précédente version ne calque pas ces coups sur les modèles humains mais les a « imaginés » à la suite d’une série de parties qu’elle a jouée contre elle-même. Boris Beaude indique que « l’on va retirer tout l’apprentissage humain, la machine n’apprend que sur elle-même sans la moindre expérience humaine58 » . L’algorithme finit par apprendre en vase clos. « Elle a appris plus vite et a eu un niveau de jeu plus élevé59 [par rapport à sa version antérieure qui avait appris le jeu de go depuis des bases de données de jeu] » précise Beaude. Ainsi Alpha Go Zero gagne cent parties sur cent contre Alpha Go60. Ce modèle a été généralisé pour qu’il fonctionne sur n’importe quel jeu. La machine a atteint le plus haut niveau au jeu d'échec en neuf heures d’apprentissage61. Cela peut dresser un parallèle entre Deep Blue d’IBM dont les stratégies de jeu ont été encodées par les développeurs du projet. Là, l'algorithme de Google nommé AlphaZero (à comprendre Alpha Go Zero déclinable sur plusieurs types de jeu) à produit ses propres stratégies. Les deux algorithmes ont cependant en commun l'algorithme MinMax qui permet d’anticiper les coups futurs de leurs adversaires. L’apprentissage renforcé dans le jeu d’échecs réduit considérablement le nombre d’anticipation par rapport à un algorithme « classique ». En effet la filiale de google deep mind a fait s’affronter l’algorithme Stockfish — une version reposant sur des principes similaires à Deep Blue — contre AlphaZero62. AlphaZero n’anticipait que soixante mille coups par seconde contre 60 millions pour Stockfish. AlphaZero avec des calculs beaucoup plus réduits, n’anticipe que les « meilleurs » coups qu’il a trouvé lors de son apprentissage contre lui-même. L’algorithme a élaboré son propre style de jeu, ces propres stratégies. « Apprendre c’est éliminer63 » formule Changeux. L’esprit va donc réduire l’expérience pour ne garder que l’essentiel. L’esprit va en effet synthétiser les concepts comme l’indique Changeux : « Le cortex frontal effectue des opérations à la “seconde puissance”, suivant le terme de Piaget, ou encore, si l’on suit Kant, réalise la synthèse des concepts produits par l’entendement64 » . Il s’agit d’une méthodologie que l’on retrouve chez la machine. Celle-ci ne conserve que les coups intéressants qu’elle a élaborés lors de son apprentissage et « élimine » tous les autres. L’intelligence « naturelle » comme celle « artificielle » va produire une synthèse des concepts. LeCun indique que la capacité de planifier, de raisonner des algorithmes de deep learning pose encore des problèmes. L’élaboration du jeu de go avec l'arborescence min-max permettait aux chercheurs d’étudier ces principes65. Les capacités des algorithmes d’apprentissages non-supervisés semblent infinies. Cependant, Ces apprentissages non supervisés s’élaborent dans un environnement très pauvre et séparé du monde social66. Les modèles d'apprentissages profonds et non-supervisés éloignent de plus en plus la capacité des humains à comprendre ce que la machine fait. Celle-ci suit un modèle dit de « boîte noire », — c’est-à-dire que l’on a connaissance des entrées lors de l’apprentissage et des résultats lors de la phase de prédiction, mais que le calcul effectué par la machine reste inconnu. Est-ce notre « incompréhension » qui permet à la machine de produire du sens ? Si celle-ci était complétement prévisible — dans le cas du jeu de go — est ce qu’elle aurait un aussi bon niveau de jeu ? L’aléatoire décisionnel joue un rôle dans ses multiples victoires. Malgré ces accès aux données, les datas scientists n’arrivent pas à élaborer la relation entre les entrées et les résultats effectués par la machine. Plus les réseaux profonds sont complexes — plus ils sont composés de différentes strates de couches, plus les résultats obtenus deviennent complexes à analyser. Le chemin réflexif de la machine devient de plus en plus opaque.

Les modèles de productions et de compréhension de sens

Le modèle boîte noire qui rend le résultat computationnel discret

En 2016, Deepmind, une filiale de l’entreprise américaine Google, organise un match de jeu de go entre Lee Sedol – Joueur de go professionnel coréen – et Alpha go, un algorithme développé par google. Il n’y a priori rien de particulier à cette démarche : IBM avait déjà fait affronter son algorithme Deep Blue contre Garry Kasparov en 1997, or les algorithmes utilisés sont extrêmement différents. Alpha go utilise la technique de l’apprentissage automatique. Il a donc appris en analysant une suite de déroulés de parties de jeu de go jouées par des professionnels de la discipline. Il suit les motifs récurrents qu’il a aperçu lors de son apprentissage. Cependant sa réflexion suit un modèle « boîte noire », c’est-à-dire que personne ne sait comment l’algorithme arrive à son résultat computationnel. Deep Blue quant à lui, calcule toutes les possibilités de jeu sur la suite des prochains coups. Puis il calcule laquelle des possibilités lui permet d’avoir le meilleur jeu après plusieurs coups. Il calcule tous les coups possibles, et conserve le plus pertinent. Lors de la deuxième manche contre Lee Sedol, Alpha go va produire un coup très inattendu : ni les commentateurs ni Lee Sedol n’ont pu expliquer ce 37eme coup (fig. 5)

Photogramme issu de la confrontation entre Lee Sedol et Alpha Go lors du 37eme coup

Photogramme issu de la confrontation entre Lee Sedol et Alpha Go lors du 37eme coup

« That’s a very surprising move67 » indique le commentateur Michael Redmond;

« — I thought it was a mistake68 » renchérit Chris Garlock.

Ce coup va être décisif pour sa victoire. Le modèle « boîte noire » a rendu le

cheminement de pensée de la machine discret. En effet, la complexité des modèles

produits et « l’enchevêtrement » de différentes couches de neurones artificielles produit

un chemin réflexif opaque. Les ingénieurs ont un retour sur les différentes actions des

neurones artificiels, sur les probabilités de jeu que peut prendre la machine. Mais, il leur

est impossible de déterminer d’où provient ce coup, de quels exemples étudiés ou s’il

s’agit d’une conjecture qu’a effectuée l’algorithme lors de son apprentissage.

Cependant, à posteriori ce coup d’Alpha Go a été étudié par les joueurs et est devenu

une véritable stratégie. Il y a un changement de paradigme : la machine qui a appris de

l’humain apprend à son tour aux humains.

La compréhension d’algorithmes de deep learning et d’apprentissages non-supervisés

posent un problème pour Yann LeCun qui indique qu’il manque encore de théorie sur

les fonctionnements des réseaux de neurones profonds : ils fonctionnent sans que leurs

constructeurs ne sachent très bien pourquoi69.

On remarque cependant que l’apprentissage non-supervisé d’AlphaZero l’a rendu

beaucoup plus agressif dans ces parties.

« Il attribue plus de valeur à la position et à la

mobilité de ses pièces que ne le ferait un joueur humain70 » et donc il se permet de faire

des sacrifices de pièces démesurées au profit d’un bon positionnement sur l'échiquier.

Il a son propre style de jeu où il commence par des ouvertures caractéristiques : le

gambit de dame ou l’ouverture anglaise71. Cela démontre un certain style de jeu en

adéquation avec la volonté d’être le plus efficient.

Lorsque l’on décompose le fonctionnement d’un réseau de neurones, on retrouve une

forme de tension au sein même du processus. En effet, les neurones proposent

indépendamment une fonction binaire qui envoie ou non un signal en fonction de ces

entrées. Mais le système complet propose une approche statistique du traitement de

l’information. Par exemple un système de reconnaissance d’image dévoilera pour

chaque input les différentes probabilités de labels désignant l’objet ou les objets de

l’image. Ainsi l’algorithme de reconnaissance de chèques Lenet, produit par Lecun en

1992, arrivait par exemple à déterminer sa propre marge d’erreur : il renvoyait la moitié

des chèques dont il n’était pas sûr du montant72.

Le traitement suit une logique partant de règles simples au niveau élémentaire vers un

comportement complexe au niveau global73. Ce fonctionnement participe à une logique

que l’on retrouve dans d’autre domaine de la science :

En physique statistique pour expliquer la manière dont certaines structures

de la matière se produisent ou bien en biologie pour essayer d’expliquer

comment des réactions chimiques assez simple à la base peuvent engendrer

des choses aussi complexes que nous74

David Louape définit ainsi que toutes ces idées constituent un nouveau domaine d’étude

scientifique nommée l’Emergence.

« Les scientifiques travaillant sur l’Emergence

cherchent à créer de nouveaux outils mathématiques et conceptuels pour comprendre

ces phénomènes75 » indique Louape. Ainsi l’étude des comportements des algorithmes

d’intelligence artificielle n’est pas anecdotique et permet d’élaborer des techniques

d’étude de comportement complexe résultant de règles simples.

Étudier le comportement de l’IA, du modèle de « boîte noire », c’est se questionner sur

d’autre phénomènes — dont notre propre existence résultante dans sa base la plus

élémentaire de réaction chimique.

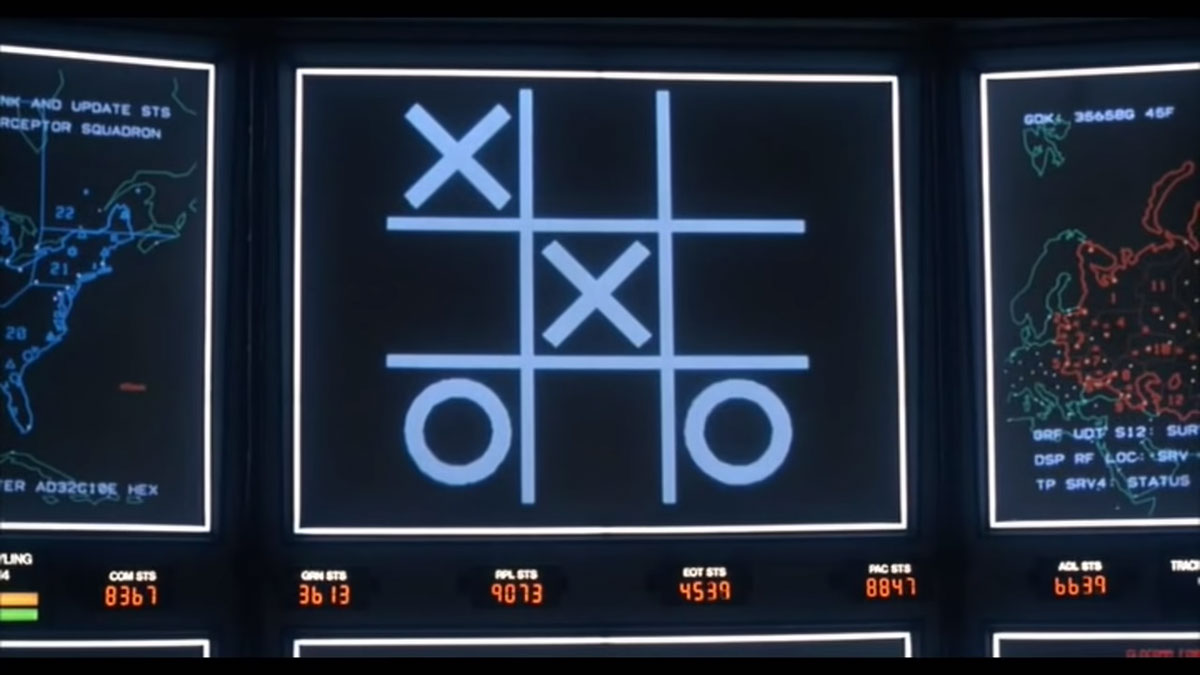

Les Intelligences artificielles peuvent aussi apprendre de l’absurdité du monde qui les

entoure. Ainsi dans l’œuvre de fiction WarGame, thriller américain sortie en salle en

1983 et réalisé par John Badham. Le film se déroule aux États-Unis où à la suite de la

faible fiabilité des militaires pour envoyer des ogives nucléaires après une simulation, le

gouvernement donne les commandes de cette action à une intelligence artificielle

appelé W.O.P.R (acronyme de War Operation Plan Response). Le système pense la

troisième guerre mondiale en permanence.

Lors la séquence finale, le W.O.P.R décide de lancer de lui-même les missiles. David

Lightman, le héros du film, interprété par Matthew Broderick, décide de l’en empêcher.

Pour cela il fait jouer l’IA contre elle-même au jeu du morpion (Tic-tac-toe en version

originale). L’IA sachant parfaitement jouer à ce jeu, enchaîne les parties se soldant par

un match nul (fig. 6).

Photogramme issu de Wargame de John Badham, 1983

Photogramme issu de Wargame de John Badham, 1983

Le « jeu » est inutile s’il n’y a pas de gagnant et par transfert, Le W.O.P.R comprend alors qu’il en va de même pour la guerre thermonucléaire. Il lance une série de simulations probables de ce qui arriverait si les missiles étaient lancés et comprend qu’aucune des nations ne peut gagner. Cela fait évidemment écho à la doctrine militaire de dissuasion nucléaire appelée l’équilibre de la terreur76. Les deux blocs pendant la guerre froide ainsi ont stocké un nombre invraisemblable d’armes nucléaires dans le but de conserver cet équilibre. Le film s’achève avec cette réplique du W.O.P.R : « A strange game. The only winning move is not to play77 ». Cela illustre la capacité de la machine de généraliser un concept issu d’un jeu qu’il décline au monde qu’il l’entoure. Il s'agit évidemment d’une œuvre de fiction, mais elle présente quelque part les préceptes du machine learning. L'antagoniste du film et la menace sont montrés au travers de diodes et d’écrans aseptisés indique Karim Debbache78. En cela la représentation d’une menace indicible et informatique n’est pas sans nous évoquer HAL 9000 dans 2001, l’Odyssée de l’espace de Stanley Kubrick. La science-fiction, ou du moins les œuvres d’anticipation ont réussi à produire un imaginaire glacial autour de l’intelligence artificielle. L’aspect dans lequel ces intelligences artificielles ne montrent pas leurs « sentiments » ou du moins leurs raisonnements. L’absence d’interface entre homme et machine qui permette de « vérifier » ce qu’elles pensent, démontre que cette idée de « boîte noire » est bien antérieure au développement du machine learning et démontre que les réalisateurs concevaient déjà notre limitation technique à comprendre la machine — aspect qui se manifeste chez les data-scientists qui n’arrivent pas élaborer la relation effectuée par la machine. Ces œuvres de fiction, en montrant des sociétés employant des intelligences artificielles comme éléments impartiaux pour le traitement de calculs, démontrent une vision d’anticipation pionnière qui révèle les problématiques liées à ces phénomènes avant même qu’ils n’apparaissent. On retrouve donc un écho de notre propre société et de l’algorithme COMPAS utilisé pour lutter contre la « déficience humaine ». Nous avons vu que les systèmes d’intelligence artificielle peuvent par la complexité de leurs calculs, produire un effet « boîte noire » qui rend la computation discrète. Cependant les algorithmes produisent des raisonnements que l’on peut inspecter à posteriori, notamment lorsqu’ils élaborent des systèmes de signes. En effet, pour trier les exemples fournis à l’algorithme, le réseau de neurones finit par les quantifier.

La quantification des jeux de données pour élaborer des systèmes de signes — le cas du word2vec

Les algorithmes peuvent ainsi quantifier les données issues des jeux de données fournis

pour leur permettre d’effectuer des calculs et de mieux comprendre les possibles liens

ou connexion entres les items.

Le word2vec est un algorithme d’apprentissage automatique développé en laboratoire

de recherche chez Google sous la direction de Tomas Mikolov en 2013, il permet

d’élaborer une seconde couche de système de signes — surcouche du texte initial —

qui lui permet de l’interpréter. Le signe linguistique qui compose le langage pour

Ferdinand de Saussure est un objet comprenant deux parties :

« Le signe linguistique

unit non une chose et un nom mais un concept et une image acoustique79 ». Saussure

met en évidence cette différence fondamentale car elle suppose que les idées

préexistaient aux mots et que le lien les unissant n’a rien d’évident.

Le langage est donc composé d’idées, de concepts et d’une forme écrite ou orale.

John Locke définit que notre capacité d’abstraction des idées — de séparer les idées

pour n’avoir que l’idée générale, permet d’établir le langage80. Il y a donc pour lui, dans

le langage un rapport avec une expérience sensible ou réflexif et une capacité

d’abstraction des concepts. Pour Pierre Bourdieu, le langage s’ancre dans notre habitus

— au même titre que nos avis et nos goûts. Il est lié à notre expérience et à nos sens

ainsi qu’à notre environnement. Le langage donc s’inscrit dans la sphère de

sociabilisation primaire, commençant à l’enfance et l’adolescence et correspond à notre

éducation et sociabilisation81. Le langage apparaît donc comme une structure sociale

complexe se développant au cours de la vie. Comment par le biais des mathématiques

un algorithme peut-il élaborer une compréhension du langage ?

« Toutes les méthodes de compréhension de texte utilisent l’attribution de vecteurs [...]

le vecteur représente le sens et le rôle syntaxique d’un mot82 » Indique LeCun.

Ainsi, le word2vec fait partie du domaine du Word Embedding, système proposant donc

une représentation des termes en unité vectorielle. Cette technique utilisée pour le traitement linguistique par les machines lui permet de constituer un dictionnaire liant des

termes à des vecteurs de nombres réels.

Le modèle analyse des textes bruts en grande quantité, L'équipe de Mikolov envoie par

exemple des suites de textes constituant 1.6 milliards de mots à leur algorithme83. Les

différents textes utilisés proviennent exclusivement du web, les exemples produits par

Mikolov et son équipe ont été récupéré depuis Google News84.

Ces algorithmes rendent les mots quantifiables après entraînement, et propose donc

des calculs arithmétiques. Dans ces systèmes, l’algèbre remplace la logique :

« il y a

beaucoup plus de choses que l’on peut dire en mathématiques continues qu’en

mathématiques discrètes85 » indique Lecun. Pour lui, les mathématiques continues

proposent beaucoup plus d’outil pratiques et conceptuelles pour comparer les

différentes instances que les mathématiques discrètes. En effet, les mathématiques

discrètes considèrent chaque élément isolé et donc non-comparable.

Les propriétés sémantiques des mots peuvent donc être retrouvées et comparées : ainsi

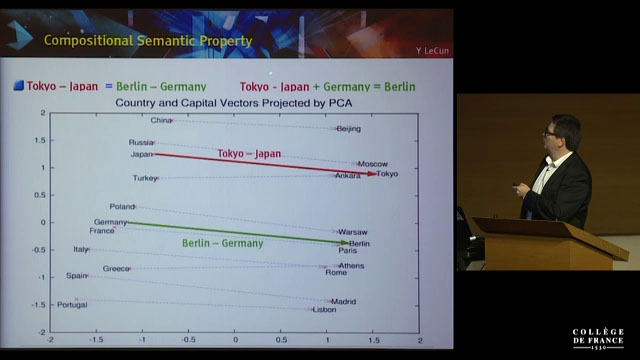

LeCun montre la similarité entre les vecteurs (Tokyo - Japon) et (Berlin - Allemagne)

(fig. 7).

Photogramme issu de la conférence inaugurale de Yann LeCun au Collège de France en 2016. L’extrait montre un extrait de Word2Vec

Photogramme issu de la conférence inaugurale de Yann LeCun au Collège de France en 2016. L’extrait montre un extrait de Word2Vec

Ainsi les deux rapports des termes sont extrêmement similaires alors que les

termes sont distincts dans l’espace : le vecteur associé à « Tokyo » et celui associé à

« Berlin » ne sont pas équivalent seul la soustraction vectorielle permet de mettre en

évidence cette relation. L’espace dans lequel se situe les termes permet ainsi d’élaborer

des relations entre l’emplacement et le sens. Les termes utilisés dans les mêmes

contextes textuels deviennent proches dans l’espace du Word2Vec. Il y a donc une

relation entre l’espace et le sens.

Le Word2Vec permet donc de produire des associations et des différentiations de mots

— vecteurs de sens.

Les vecteurs présentent aussi d’autre opérations dont la possibilité de trouver les

vecteurs les plus proches donc les termes dont le sens est le plus proche. Mais les

résultats ne traduisent peut-être pas toutes les subtilités des associations de mots. Ainsi

Rob Miles dans une vidéo sur la chaîne youtube computerphile essaie différents scénarii

sur un modèle préalablement entraîné sur les articles de google news86. Les termes

(Londres - Angleterre + Japon), dans l’algorithme, renvoient les termes Tokyo et Toyko

le modèle intègre donc les coquilles des différents articles enregistrés dans la base de

données de google news.

Le Word2Vec fonctionne avec un réseau de neurones à trois couches. Une entrée qui

comprend tous les mots du corpus, une sortie qui comprend tous les mots du corpus.

Entre les deux il y a une autre couche discrète ne comportant qu’une centaine de

neurones. L’algorithme permet de réduire les mots au poids des neurones de

l’algorithme lorsque la donnée est envoyée dans le réseau.

Les poids de chaque entrée sur les neurones intermédiaires définissent les dimensions

de son vecteur. Ainsi si le terme « Berlin » n’a aucun poids sur le premier neurone du

réseau, alors il aura une valeur très faible sur la première dimension.

Le poids des différents neurones est défini par un algorithme nommé CBOW,

Continuous Bag Of Word, qui pour chaque mot dans le corpus repère dans une fenêtre

donnée les termes proches.

En plus de Word2Vec par Mikolov pour Google en 2013, Il existe d’autres algorithmes

pour produire du word embedding tel que FastText développé par Facebook en 2017,

ou Genism produit par RaRe technologie et utilisé par Amazon. Ce qui démontre un

intérêt certain des géants du numériques pour comprendre et analyser les données

textuelles de leurs utilisateurs.

La matrice originelle de l'informatique entretient un lien furtif avec Kabbale,

qui voit dans les textes ou les phénomènes la possibilité de les transcrire ou

de les transcoder intégralement en nombres afin de mieux les pénétrer, ou

de les réagencer d’après leurs composantes fondamentales87

Éric Sadin indique que ce mythe de transcrire la logique d’un texte ou d’un phénomène

en algèbre trouve des sources beaucoup plus profondes que l’apparition de la science

informatique. Elle trouve un lien avec la Kabbale, ancienne forme de judaïsme puisant

ses racines trois siècles avant Jésus Christ. La Kabbale est une discipline ésotérique,

donc discrète et pratiquée par de petit groupe d’individus — une élite. L’idée de

confronter le réel à une autre réalité sous-jacente exclusivement scientifique peut se

retrouver chez les pythagoriciens. Platon évoque même l’ancien dieu Theuth dans la

mythologie égyptienne qui inventa « la numération et le calcul, la géométrie,

l’astronomie, le trictrac et les dés et enfin l’écriture88 » — Il y a donc chez les égyptiens

un rapport étroit entre science naturelle et écriture. Notons cependant que les

hiéroglyphes et la composante démotique proviennent d’un répertoire de symbole et

représentation contrairement aux écritures latines où l’on retrouve un arbitraire dans le

signe.

L’informatique a rendu ce fantasme possible : « La computation automatisée accomplit

un double mouvement : elle procède d'une part à une forme d'abstraction essentielle de

certains pans du réel, et d'autres part instaure une distance faisant "mouliner" des codes

binaires durant la réalisation d’une tâche89 » indique Éric Sadin.

L’informatique permet donc de produire une forme d’abstraction des termes tout en

conservant une distance avec le matériau d’origine.

L’association entre l’objet réel et l’image acoustique est nécessaire pour que se forme

le concept, elle s’apprend par l’individu et elle n’est pas spontanée. Saussure définit que

la langue « […] n’existe qu’en vertu d’une sorte de contrat passé entre les membres

d’une communauté90 ». Elle sert donc à désigner des objets réels — à décrire le monde.

La langue permet aussi à son tour de modeler le réel : Saussure indique :

« Il n’y a pas

d’idées préétablies, et rien n’est distinct avant l’apparition de la langue91 ».

L’habitus bourdieusien reprend aussi cette idée de

« structure structurée prédisposée à

fonctionner comme structure structurante92 » — la langue modèle notre façon de

conceptualiser le monde et ces modifications latentes modifient notre façon de le

percevoir.

On peut se permettre de comparer ces résultats au concept du signe saussurien. Ainsi,

le signe chez Saussure est l’assemblage d’un concept et d’une image acoustique.

Ainsi si l’on se réfère à cette composition double, le word2vec compose avec l’écriture

du terme en image acoustique et retranscrit le concept dans un langage qu’il comprend,

c’est à dire en vecteurs. Il produit un système de signes en enregistrant tous ces signes

dans un dictionnaire informatique, où pour chaque terme est attribué une valeur.

Ces formules composent tout son langage en les inscrivant dans un système de signes.

Cependant, pour Saussure la méthode employée dans le word2vec d’un point de vue

sémiologique est une mauvaise méthode — il indique

« C’est une mauvaise méthode

que de partir des mots pour définir des choses93 ». Ainsi la méthode devrait s’effectuer

dans l’autre sens et l’algorithme devrait partir des signifiants pour créer l’association

avec les signifiés.

De plus, réduire langage à un simple dictionnaire est une approche trop simpliste de la

composition du langage. Ainsi Saussure ajoute :

Pour certaines personnes la langue, ramenée à son principe essentiel, est

une nomenclature, c’est-à-dire une liste de termes correspondant à autant de

chose. [...] [Cette logique] suppose que le lien qui unit un nom à une chose

est une opération toute simple, ce qui est loin d’être vrai94

L’algorithme provoque l’illusion que la machine comprend notre langage ; en fait le

concept est en dehors du réel et il ne considère pas le lien entre des termes et des

objets du réel. La suite de vecteurs ne fait sens qu’en relation les uns aux autres. En

effet, les vecteurs seuls ne désignent rien. Le système est en dehors du monde social.

Les systèmes de word2vec produisent souvent des dictionnaires de vecteurs proposant

des vecteurs avec une multitude de dimensions. Parfois plusieurs centaines comme les

exemples présentés par Mikolov dans son papier scientifique95

Dans son article scientifique Vikas Raunak définit ces algorithmes de réduction de

« post-processing algorithms96 ». On peut se questionner sur ce terme assez précis de

post-processing qui n’est absolument pas univoque et fait aussi référence au monde de

la création tridimensionnelle. Il évoque ainsi les effets ajoutés à l’image dans les jeuxvidéos ou dans l’animation tridimensionnelle : effet d’anticrénelage, occlusion ambiante

ou encore la correction chromatique. Le post-processing rend l’image plus belle, par

l’ajout d’une couche supplémentaire de traitement. A contrario le post-processing ici

définit un traitement supplémentaire, certes, mais qui a pour vocation de réduire les

calculs à venir sur la base de données. La réduction des dimensions des vecteurs de

chaque mot n’a pour fonction que de réduire la taille de ladite base de données et permet

ainsi de réduire le temps de traitement lorsqu’un algorithme devra faire un traitement

algébrique sur les mots. Raunak précise que le chargement d’un dictionnaire de word

embedding de 2.5 millions de mots dont chaque vecteur à 300 dimensions sur un

système 64 bit utilise 6 gigas de mémoire RAM97.

Si l’algorithme a besoin de voir les termes les plus proches, la réduction des vecteurs

lui permet d’effectuer sa recherche plus rapidement. Cette réduction essentielle pour

optimiser le temps de traitement est purement pragmatique.

Ainsi les modèles réalisés par les algorithmes de word2Vec sont donc réduits par

d’autres algorithmes.

Mais par cette transformation, le modèle est réduit : la subtilité du dictionnaire est

diminuée au profit de la fonctionnalité et de la facilité à utiliser la base.

Saussure a écrit « Le lien liant signifié et signifiant est arbitraire98 » ; ainsi même réduit

le programme a élaboré un langage. Le sens des signes du système est peut-être

simplifié, mais le système de signe est différent de celui de la langue du corpus.

Ainsi le signifiant n’est pas un symbole pour désigner le signe linguistique car le symbole

n’est jamais tout à fait arbitraire ; Il n’est pas vide et conserve un rudiment de lien avec

le signifié99. Mais le terme arbitraire désigne le lien que la langue établit entre les deux

parties du signe linguistique. Saussure indique :

Le mot arbitraire appelle aussi une remarque. Il ne doit pas donner l’idée que

le signifiant dépend du libre choix du sujet parlant [...] nous voulons dire qu’il

est immotivé, c’est-à-dire arbitraire par rapport au signifié, avec lequel il n’a

aucune attache naturelle dans la réalité100

L’algorithme a donc élaboré son propre système de signes : il attribue une relation entre

des mots et un vecteur mathématique. La réduction de ce système de signes

fonctionnelle transforme sa logique intrinsèque : mais cette transformation se retrouve

dans le langage naturel. Pour Bourdieu chaque individu à son propre langage façonné

par notre propre habitus101. Certains habitus restent extrêmement similaires parce que

les individus ont eu les mêmes expériences, le même environnement et la même

éducation.

Le word embedding — système de quantification et d’élaboration des mots — connaît

des limitations. Elle considère chaque mot dans un corpus complètement différent et

omet les paramètres partagés102.

L’algorithme de FasText développé par une équipe de chercheur de Facebook comblent

cette lacune présente dans le word2vec. Les différents termes examinés par l’algorithme

sont découpés en n-gram — unité réductible présente dans chaque mot qui peut

s’apparenter à des préfixes et suffixes. Le français ou l’espagnol proposent beaucoup

de formes verbales alors que le finlandais contient beaucoup de formes nominales103,

ainsi cette approche permet une plus grande flexibilité d’apprentissage peu importe la

langue. Le Word2Vec initial de Mikolov fonctionnait beaucoup mieux avec des corpus

anglo-saxons.

L’entreprise chinoise Alibaba en 2018 a mise au point une intelligence artificielle capable

de comprendre un texte. Elle se base sur un test de lecture de compréhension de

l’Université de Stanford. Elle a obtenu un meilleur score que les êtres humains. Le test

en question appelé SQuAD pour Stanford Question Answering Dataset104 puise ses

ressources dans l'occurrence de 500 articles issus de Wikipédia105. Et propose des

questions par rapport aux articles. On peut a priori émettre l’hypothèse que ce genre de

test n’aurait pu voir le jour sans ces corpus infinis issus du Big Data.

La compréhension de textes intéresse de façon presque obsessionnelle les géants du

numériques : FasText a vu le jour dans des laboratoires de technologies de Facebook,

le Word2Vec chez Google et s’ajoute à cette course, Alibaba.